Apple deve apresentar a Siri turbinada com Gemini em fevereiro

Apple deve apresentar a Siri turbinada com Gemini em fevereiro

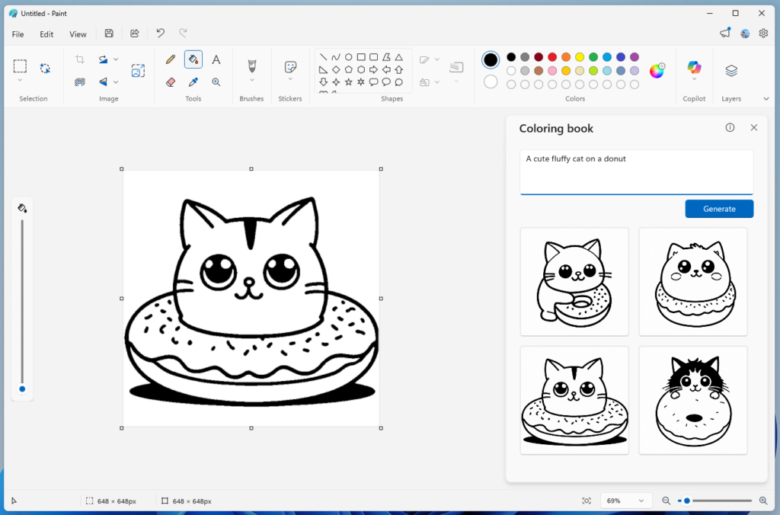

Nova assistente poderá resumir documentos e cruzar dados entre aplicativos (imagem: Vitor Pádua/Tecnoblog)

Resumo

A Apple planeja lançar uma Siri reformulada com o Gemini em fevereiro de 2026, com uma reformulação completa prevista para o final de 2026.

A nova Siri, sob o codinome “Campos”, terá diálogos contínuos e interações profundas com aplicativos da Apple, utilizando cerca de 1,2 trilhão de parâmetros.

A parceria com o Google foi consolidada em novembro de 2025, após negociações com a Anthropic e a OpenAI falharem.

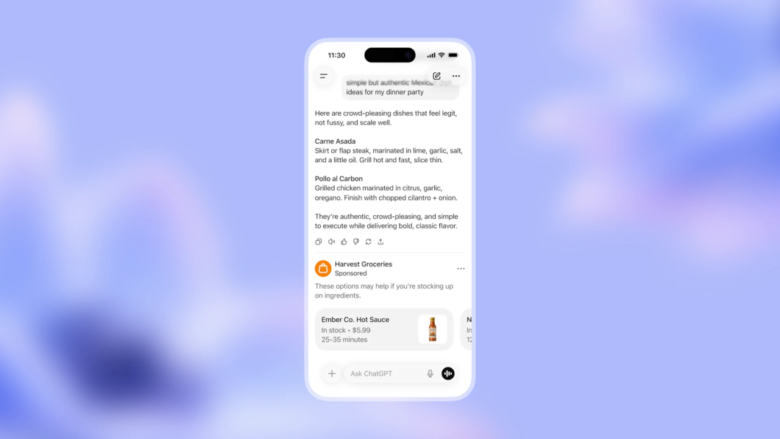

A Apple planeja realizar, na segunda quinzena de fevereiro de 2026, a primeira demonstração oficial da Siri reformulada com inteligência artificial do Google. A ideia é apresentar os resultados da parceria firmada entre as duas gigantes de tecnologia, o que deve marcar a transição da assistente para um modelo de chatbot.

O anúncio, se confirmado, ocorre após atrasos internos no desenvolvimento e visa recuperar o terreno perdido para concorrentes como a OpenAI, dona do ChatGPT, no setor de IA generativa.

O que muda com a nova Siri?

A grande mudança será a capacidade da assistente de manter diálogos contínuos e contextuais, de forma mais próxima à experiência oferecida pelo ChatGPT e pelo próprio Gemini. O novo sistema – desenvolvido sob o codinome “Campos” – permitirá que a Siri interaja de forma profunda com aplicativos nativos do ecossistema da Apple, como Mail, Música, Fotos e até o ambiente de desenvolvimento Xcode.

A Apple denomina a tecnologia como Apple Foundation Models na versão 10. Ela opera com cerca de 1,2 trilhão de parâmetros e será inicialmente hospedada nos servidores de computação em nuvem privada da empresa, o PCC. Com o lançamento do iOS 27 e macOS 27, a arquitetura passará a utilizar a versão 11, com maior capacidade de processamento e execução direta na infraestrutura de nuvem do Google.

Entre as novas funcionalidades previstas estão:

Análise de documentos: capacidade de resumir arquivos enviados pelo usuário

Edição de mídia: realizar comandos complexos em imagens por comando de voz (como recortes e ajustes de cor)

Gestão de dados: localizar e cruzar informações com maior precisão

Na prática, um usuário poderá solicitar que a Siri localize um email de meses atrás e escreva uma resposta baseada em informações da agenda pessoal, por exemplo, cruzando dados de diferentes fontes sem a necessidade de intervenção manual entre os apps.

Siri utilizará tecnologia do Gemini para processar tarefas complexas (foto: Thássius Veloso/Tecnoblog)

Quando será o lançamento?

Segundo informações apuradas por Mark Gurman, da Bloomberg, a nova Siri será liberada em fases. A primeira etapa acompanhará o iOS 26.4, com lançamento esperado entre março e abril. Nesta versão, a assistente começará a utilizar o processamento do Gemini para lidar com tarefas complexas. A interface visual completa e a arquitetura definitiva devem ser reservadas no segundo semestre de 2026.

A decisão de adotar o Gemini reflete uma mudança na gestão de software da companhia. O projeto, agora liderado por Craig Federighi, chefe de engenharia de software, ganhou prioridade após a diretoria expressar insatisfação com o progresso dos modelos internos.

A parceria com o Google foi consolidada em novembro de 2025, após negociações com a Anthropic e a OpenAI não avançarem devido a divergências financeiras e conflitos estratégicos. Para a Apple, o uso do Gemini é visto como uma solução de curto prazo para entregar funcionalidades competitivas enquanto a empresa amadurece sua própria infraestrutura de inteligência artificial.

Apple deve apresentar a Siri turbinada com Gemini em fevereiro

Apple deve apresentar a Siri turbinada com Gemini em fevereiro

Fonte: Tecnoblog