O que é Deep Learning? Entenda como funciona e conheça suas principais aplicações

O que é Deep Learning? Entenda como funciona e conheça suas principais aplicações

Conheça como funciona e as aplicações da Deep Learning (ilustração: Vitor Pádua/Tecnoblog)

O Deep Learning, ou Aprendizado Profundo, em português, é um ramo da Inteligência Artificial (IA) que “ensina” máquinas a aprender por meio de dados. Para isso, são usadas redes neurais artificiais que simulam o cérebro humano para identificar padrões complexos e gerar respostas e previsões.

Essa tecnologia está presente em diversas áreas e aplicações do nosso dia a dia. Por exemplo, reconhecimento facial, assistentes virtuais, dispositivos de Internet das Coisas (IoT), mecanismos de recomendações em sites e sistemas de carros autônomos.

A seguir, entenda o que é Deep Learning, seu funcionamento e aplicações. Também descubra os pontos positivos e negativos do uso da tecnologia.

ÍndiceO que é Deep Learning?Como funciona o Deep Learning?Quais são os exemplos de aplicações de Deep Learning?Quais são as vantagens de usar Deep Learning?Quais são as desvantagens de usar Deep Learning?Qual é a diferença entre Inteligência Artificial e Deep Learning?Qual é a diferença entre Deep Learning e Machine Learning?Qual é a diferença entre Redes Neurais e Deep Learning?

O que é Deep Learning?

O Deep Learning é um subcampo do Machine Learning que usa redes neurais artificiais com múltiplas camadas para aprender hierarquia de dados. Como se fosse neurônios de um cérebro humano, essas camadas processam a informação de forma sequencial, permitindo que o sistema aprenda padrões e faça previsões com precisão.

Como funciona o Deep Learning?

Um modelo de Deep Learning é como uma rede de neurônios artificiais, organizada em camadas. Cada neurônio, chamado de nó interconectado, processa informações e passa o resultado para os neurônios da próxima camada.

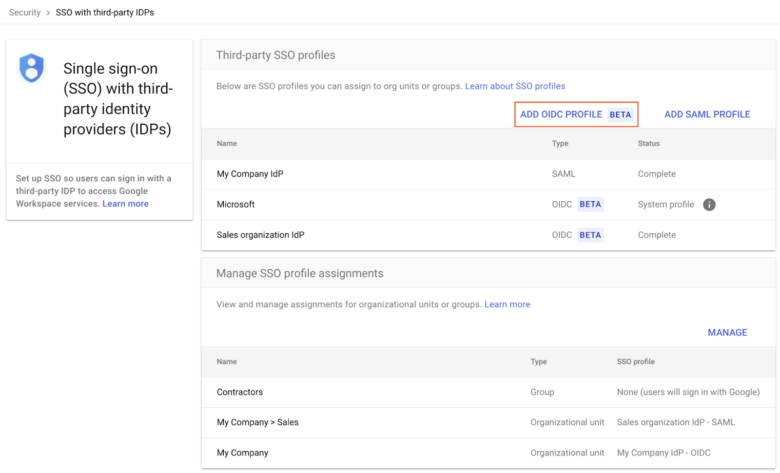

Durante o treinamento do algoritmo, o modelo ajusta os pesos das conexões entre os neurônios para aprender a mapear os dados de entrada e gerar os resultados. As principais camadas do modelo de Aprendizado Profundo são:

Camada de entrada: recebe os dados brutos, como uma imagem ou palavras de um texto;

Camadas ocultas: realizam cálculos complexos para extrair características relevantes dos dados, como as relações entre palavras. O número de camadas ocultas e a complexidade dos cálculos variam conforme a tarefa;

Camada de saída: produz a resposta final, que pode ser uma classificação (por exemplo, a imagem de um gato ou cachorro), uma previsão (como valores da ação de uma empresa), um texto ou outra forma de saída.

É importante dizer que existem diferentes tipos de redes neurais artificiais, cada uma com arquitetura e aplicações específicas. Por exemplo, as redes convolucionais (CNNs) para imagens e as redes recorrentes (RNNs) para sequências de dados.

As camadas de aplicações do Deep Learning (ilustração: Vitor Pádua/Tecnoblog)

Quais são os exemplos de aplicações de Deep Learning?

O Deep Learning está presente em várias aplicações do nosso dia a dia. Por exemplo:

Visão computacional: extração de informações e insights de imagens e vídeos, como a moderação de conteúdos em sites e redes sociais, removendo arquivos inapropriados;

Reconhecimento de voz: análise da fala humana a partir de padrões, como idioma. Comum em assistentes virtuais, como Amazon Alexa, dispositivos de Internet das Coisas (IoT) e aplicativos com suporte para text-to-speech e speech-to-text;

Processamento de linguagem natural: organização de dados de texto para treinar chatbots, indexação de expressões-chave em mídias sociais e resumos automáticos de documentos e artigos jornalísticos;

Mecanismo de recomendação: rastreio das atividades e comportamento de um usuário para desenvolver recomendações personalizadas de serviços e produtos. Comum em serviços de streaming, redes sociais e e-commerces;

Refinamento de dados: processamento de dados brutos visando identificar padrões e extrair insights;

Finanças: avaliação de dados para previsão de mercado, detecção de fraudes e recomendação de investimentos;

Veículos autônomos: sistema de identificação de fatores externos, como carros ao redor, placas de rua e pedestres, gerando uma reação para o veículo;

Jogos: criação de personagens não jogáveis (NPCs) mais inteligentes e realistas;

IA generativa: geração de conteúdos e comunicação com os usuários, proporcionando a automatização do fluxo de trabalho e busca inteligente de conhecimento.

Quais são as vantagens de usar Deep Learning?

O Deep Learning oferece várias vantagens que o tornam uma ferramenta poderosa para a resolução de problemas complexos. As principais são:

Alta precisão: os algoritmos têm alto desempenho em tarefas como reconhecimento de imagem (por exemplo, em carros autônomos) e processamento de linguagem natural (como em assistentes virtuais);

Automatização da engenharia de recursos: ao contrário de métodos tradicionais, o Deep Learning aprende automaticamente as características mais relevantes dos dados, eliminando a necessidade de intervenção manual;

Escalabilidade: modelos de Aprendizado Profundo podem ser treinados com grandes volumes de dados, sendo ideias para aplicações em larga escala;

Flexibilidade: os algoritmos são adaptáveis a diversos tipos de dados (imagem, texto, áudio) e podem ser aplicados em uma gama de soluções;

Aprendizado contínuo: uma característica fundamental do Deep Learning é a capacidade de melhorar o desempenho ao longo do tempo, à medida que mais dados são disponibilizados.

Quais são as desvantagens de usar Deep Learning?

O Deep Learning, apesar de seus avanços, apresenta alguns desafios. Entre eles, destacam-se:

Altos demanda computacional: o treinamento de modelos de Deep Learning exige grande poder computacional, como GPUs e TPUs, além de grande quantidade de memória RAM;

Necessidade de grandes conjuntos de dados rotulados: a construção de modelos robustos requer vastas quantidades de dados de alta qualidade, devidamente classificados por especialistas. Esse processo pode ser custoso e demorado;

Dificuldade de interpretação: os modelos de Deep Learning são frequentemente considerados “caixas pretas”, pois é difícil entender o raciocínio por trás das decisões. Essa falta de transparência pode ser um obstáculo em áreas como medicina e direito;

Overfitting: os modelos podem se ancorar aos dados de treinamento, perdendo a capacidade de gerar novos dados. Isso ocorre quando o modelo memoriza os exemplos de treinamento em vez de aprender as características gerais dos dados. Para evitar o overfitting, são usadas técnicas como regularização e validação cruzada.

Infográfico apresenta a relação entre IA, Processamento de Linguagem Natural, Grandes Modelos de Linguagem, Machine Learning e Deep Learning (Imagem: Vitor Pádua/Tecnoblog)

Qual é a diferença entre Inteligência Artificial e Deep Learning?

A Inteligência Artificial (IA) é um campo amplo que busca criar máquinas capazes de realizar tarefas que exigem inteligência humana. Assim, o Machine Learning, subcampo da IA, permite que as máquinas aprendam com dados sem serem diretamente programadas.

O Deep Learning é um subcampo do Machine Learning que usa redes neurais artificiais inspiradas no cérebro humano. Essas redes são compostas por camadas de neurônios artificiais que processam informações de forma hierárquica, permitindo o aprendizado de padrões complexos em grandes volumes de dados.

Qual é a diferença entre Deep Learning e Machine Learning?

Deep Learning é um subcampo do Machine Learning que usa redes neurais artificiais com múltiplas camadas para aprender representações hierárquicas dos dados. Essas redes, inspiradas no funcionamento do cérebro humano, são capazes de lidar com grandes volumes de dados não rotulados, como imagens, vídeos e textos.

Machine Learning é um ramo da IA que permite que sistemas aprendam com dados, identificando padrões e fazendo previsões sem serem diretamente programados. O processo de aprendizagem pode ser supervisionado (dados do treinamento com respostas corretas) ou não supervisionado (busca de padrões em dados não rotulados).

Qual é a diferença entre Redes Neurais e Deep Learning?

As redes neurais artificiais são a base do Deep Learning. A tecnologia é composta por camadas de nós interconectados, que processam informações de forma semelhante aos neurônios do cérebro humano, aprendendo com os erros e aprimorando continuamente.

O Deep Learning é um subcampo da IA que ensina máquinas a processar dados de forma semelhante ao cérebro humano. Para isso, as redes neurais são usadas no processo de reconhecer padrões de dados e gerar previsões precisas.

O que é Deep Learning? Entenda como funciona e conheça suas principais aplicações

O que é Deep Learning? Entenda como funciona e conheça suas principais aplicações

Fonte: Tecnoblog