Fundador da DeepMind diz que onda de IA atraiu vigaristas

Fundador da DeepMind diz que onda de IA atraiu vigaristas

Para Demis Hassabis, hype da inteligência artificial trouxe vigaristas para esta área e prejudica profissionais sérios (Imagem: Vitor Pádua / Tecnoblog)

Demis Hassabis, um dos fundadores da empresa de inteligência artificial DeepMind, declarou que a onda de IAs trouxe muitos vigaristas para a área. Hassabis, que é chefe da divisão de IA do Google, comparou o hype das inteligências artificiais com a febre de criptomoedas. O executivo da big tech destaca que alguns desses vigaristas estão recebendo bilhões em investimento.

A comparação com criptomoedas pode deixar alguns admiradores de criptos bravos, mas a fala de Hassabis tem lógica. Nos últimos anos, com a alta valorização de criptomoedas como o Bitcoin e Ethereum, diversos vigaristas passaram a usar o assunto para aplicar golpes, seja com agências de investimento em cripto ou criando suas próprias moedas. Para o cofundador da DeepMind, o hype com IAs trouxe esses mesmos problemas.

Por outro lado, Hassabis comenta um paradoxo: em alguns pontos, IA não é “hypada” o bastante, mas em outros ela é superestimada. “Nós estamos falando de coisas que não são reais”, disse o inglês.

Marketing com termo IA é quase um 1º de abril

A declaração do fundador da DeepMind foi dada no domingo, dia 31. No entanto, ela combina com o dia de hoje, 1º de abril, o dia da mentira. Não que alguma pegadinha envolvendo IA tenha viralizado. Só que desde o boom dessa tecnologia, diversas empresas estão usando o termo “inteligência artificial” para recursos que não são IA.

Demis Hassabis, à esquerda, e sua DeepMind criaram a AlphaGo, IA que venceu Lee Sedol, campeão mundial de go (Imagem: Divulgação/DeepMind)

O problema é que, em alguns casos, essas tecnologias utilizam um algoritmo complexo, capaz de analisar padrões já programados. Sendo mais “purista” na definição, inteligência artificial é um modelo capaz de aprender sozinho e tomar decisões sem ajuda de um humano.

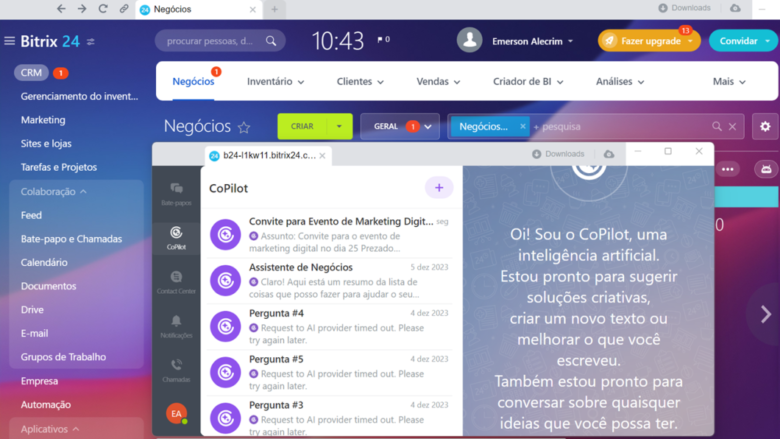

Um exemplo desse uso do termo IA como marketing: provavelmente você já viu um chatbot sendo anunciado como inteligência artificial. Mas que na prática é apenas um algoritmo que vai identificar palavras chaves e te responder — além de te fazer passar raiva, porque geralmente são mal estruturados e incapazes de te ajudar. E não citarei nomes de empresas.

Hype prejudica pesquisas em IA, diz Hassabis

Hassabis destaca que esses problemas com a “febre de IA” acaba jogando uma nuvem sobre a ciência e pesquisa por trás dessa tecnologia. Enquanto algumas pessoas acreditam que IAs são apenas um hype passageiro ou que não serão tudo isso, o executivo defende o oposto.

“Eu acho que nós estamos arranhando apenas a superfície do que eu acredito que será possível na próxima década em diante”, disse Hassabis. O inglês formado em ciências da computação ainda afirma que estamos no início de uma nova era de ouro das descobertas científicas, “um novo Renascimento”, diz o executivo.

Com informações: Financial Times e The Verge

Fundador da DeepMind diz que onda de IA atraiu vigaristas

Fundador da DeepMind diz que onda de IA atraiu vigaristas

Fonte: Tecnoblog