Samsung anuncia nova linha Galaxy Book 4 com foco em Inteligência Artificial

Samsung anuncia nova linha Galaxy Book 4 com foco em Inteligência Artificial

Galaxy Book 4 Ultra é o mais robusto da nova linha de notebooks da Samsung (Foto: Katarina Bandeira/Tecnoblog)

(São Paulo) A Samsung anunciou nesta quarta-feira (17) os novos notebooks da linha Galaxy Book 4. Chegam ao mercado brasileiro as versões Galaxy Book 4 Ultra, Galaxy Book 4 Pro e Galaxy Book 4 360. Já o modelo tradicional do computador portátil só deve desembarcar no país em junho. O Tecnoblog teve acesso aos produtos em primeira mão e traz, nas linhas a seguir, o resumo do que o consumidor pode encontrar nos aparelhos.

O grande destaque do evento ficou por conta dos modelos Galaxy Book 4 Ultra e Pro. Para essa linha, os notebooks ganharam novos recursos na tela, assim como melhorias na ficha técnica. Foram inseridos o recém-lançado processador Intel Core Ultra e a NPU AI Engine, que melhora o processamento da inteligência artificial nos dispositivos, segundo a fabricante.

“Conforme os aplicativos estão sendo remodelados, estão sendo adaptados para inteligência artificial, eles aprendem a melhor forma de utilizar a NPU. Você tem um ganho [de processamento] de 2.3x, que é bastante substancial”, explica Luciano Beraldo, gerente sênior de notebooks da Samsung Brasil.

Galaxy Book 4 Ultra e Pro ganham reforço para IA

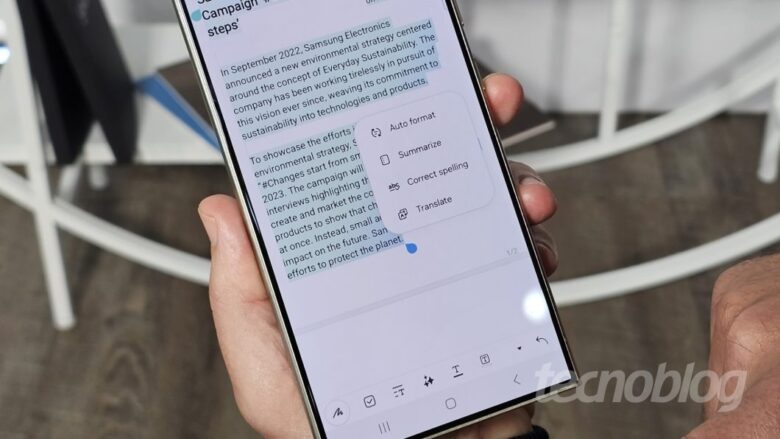

Nova linha de notebooks da Samsung vai focar em Inteligência Artificial (Foto: Katarina Bandeira/Tecnoblog)

Pensado para o público gamer, o Galaxy Book 4 Ultra vem com uma tela de 16 polegadas em AMOLED Dinâmico 2x, com resolução WQXGA+ (2880×1800) — a mesma presente no modelo lançado no ano passado — e taxa de resolução de 120 Hz. A diferença é que, dessa vez, o notebook premium da Samsung ganha um display sensível ao toque e antirreflexo – algo que antes era uma exclusividade do Book 360.

O dispositivo pode ser encontrado em duas versões. A primeira, equipada com o chip Intel Core Ultra 9, acompanhada da placa de vídeo da NVIDIA, RTX 4070 e a segunda, com o processador Intel Core Ultra 7 e placa de vídeo RTX 4050. Além disso, o Book 4 Ultra ainda conta com 32 GB de RAM e 1 TB em SSD, expansível via Micro SD, que o deixa pronto para rodar jogos com gráficos pesados, assim como processar de forma ágil aplicações que usam IA.

No Galaxy Book 4 Pro, a Samsung traz um notebook que tenta conquistar o coração de quem busca trabalhar com IA. O aparelho conta com uma tela de 14 polegadas, nas mesmas configurações do seu irmão mais robusto, além do processador Intel Core Ultra 7 e NPU AI Engine.

A diferença aqui fica por conta da placa de vídeo, que é Intel ARC e da quantidade de memória e armazenamento, disponível em 16 GB RAM e 1 TB SSD. Por fim, a bateria do Galaxy Book 4 Ultra promete até 22 horas de reprodução de vídeo, enquanto o Galaxy Book 4, segue com até 18 horas de duração nas mesmas condições.

Samsung está deixando o Galaxy Book 4 360 de lado?

Galaxy Book 4 360, da Samsung, recebeu poucas melhorias (Foto: Katarina Bandeira/Tecnoblog)

Para o Galaxy Book 4 360, a Samsung trouxe poucas novidades. A tela de 13 polegadas foi abandonada de vez, restando apenas o modelo com um display de Super AMOLED com 15,6 polegadas, Full HD.

A taxa de atualização caiu pela metade — para 60 Hz — em comparação ao modelo lançado no ano passado. Uma decisão no mínimo estranha, uma vez que a proposta do dispositivo 2 em 1 é justamente oferecer a experiência de tablet, e a redução deve impactar na fluidez — principalmente quando o dispositivo for usado com a S Pen.

O modelo também não conta com algumas das configurações presentes nas versões Pro e Ultra, como a NPU IA Engine e o processador Core Ultra, equipado com o chip i7 ou i5, de 13ª geração da Intel. A bateria aguenta até 22 horas de reprodução de vídeo, com 8 ou 16 GB de RAM e até 1 TB de armazenamento SSD, expansível.

Novos recursos de IA são apostas da Samsung

Para ajudar ainda mais a popularizar o uso da inteligência artificial, os computadores portáteis da Samsung vêm equipados com Windows 11. O sistema da Microsoft traz o Copilot, chatbot de IA da própria fabricante.

Entre os recursos adicionados aos modelos Pro e Ultra estão um cancelamento de ruído que utiliza IA para identificar a voz do usuário e ferramentas de remasterização de imagens na edição nativa do app Fotos — com direito a apagador de objeto e removedor de reflexos e efeitos de estúdio.

Preço e disponibilidade

Galaxy Book 4 360 e modelo tradicional ficaram de fora das especificações robustas para Inteligência Artificial (Foto: Katarina Bandeira/Tecnoblog)

A Samsung ainda não revelou os preços de cada modelo. O Galaxy Book 4 tradicional é o único que estará disponível apenas em junho. As versões Ultra, Pro e 360 chegam ao mercado brasileiro a partir desta quarta-feira.

Ficha técnica do Galaxy Book 4 Ultra

Tela: 16″ e resolução WQXGA+ (2880×1800 pixels)

Tipo de painel: AMOLED Dinâmico 2x

Taxa de atualização: 120 Hz

Processador: Intel Core Ultra 9 ou 7

GPU: NVIDIA RTX 4070 ou RTX 4050

NPU: IA Engine

Memória RAM: 32 GB

Armazenamento: 1 TB SSD, expansível

Bateria: até 21 horas de reprodução de vídeo

Cores: Grafite

Ficha técnica do Galaxy Book 4 Pro

Tela: 13″ e resolução WQXGA+ (2880×1800 pixels)

Tipo de painel: AMOLED Dinâmico 2x

Taxa de atualização: 120 Hz

Processador: Intel Core Ultra 7

GPU: Intel ARC

NPU: IA Engine

Memória RAM: 16 GB

Armazenamento: 1 TB SSD

Bateria: até 18 horas de reprodução de vídeo

Cores: Grafite

Ficha técnica do Galaxy Book 4 360

Tela: 15,6″ e resolução Full HD (1920 x 1080 pixels)

Tipo de painel: Super AMOLED

Taxa de atualização: 60 Hz

Processador: Intel Core i7 ou i5

GPU: Intel Graphics

NPU: Não tem

Memória RAM: 8 GB ou 16 GB

Armazenamento: até 1 TB SSD, expansível.

Bateria: até 22 horas de reprodução de vídeo

Cores: Grafite

Ficha técnica do Galaxy Book 4

Tela: 15,6″ e resolução Full HD (1920 x 1080 pixels)

Tipo de painel: LCD IPS

Taxa de atualização: 60 Hz

Processador: Intel Core i7/i5/i3

GPU: NVIDIA MX570A

NPU: Não tem

Memória RAM: 8 GB ou 16 GB

Armazenamento: até 1 TB SSD

Bateria: até 15 horas de reprodução de vídeo

Cores: Grafite

Katarina Bandeira viajou para São Paulo (SP) a convite da Samsung

Samsung anuncia nova linha Galaxy Book 4 com foco em Inteligência Artificial

Samsung anuncia nova linha Galaxy Book 4 com foco em Inteligência Artificial

Fonte: Tecnoblog