GPT-5.4 chega com capacidade nativa de usar computadores

GPT-5.4 chega com capacidade nativa de usar computadores

ChatGPT começou a liberar acesso ao GPT-5.4, mas só para quem paga (ilustração: Vitor Pádua/Tecnoblog)

Resumo

O GPT-5.4 da OpenAI executa tarefas em programas de computador capturando imagens da tela e enviando comandos de mouse e teclado. Ele também escreve códigos e conecta-se a APIs.

Disponível no ChatGPT para assinantes dos planos Plus, Team e Pro, o GPT-5.4 oferece um plano de raciocínio antes de executar tarefas. Ele também está no Codex e via API.

A OpenAI está em disputa com a Anthropic, com desentendimentos públicos e diferenças em parcerias, como a colaboração da OpenAI com o Departamento de Defesa dos EUA.

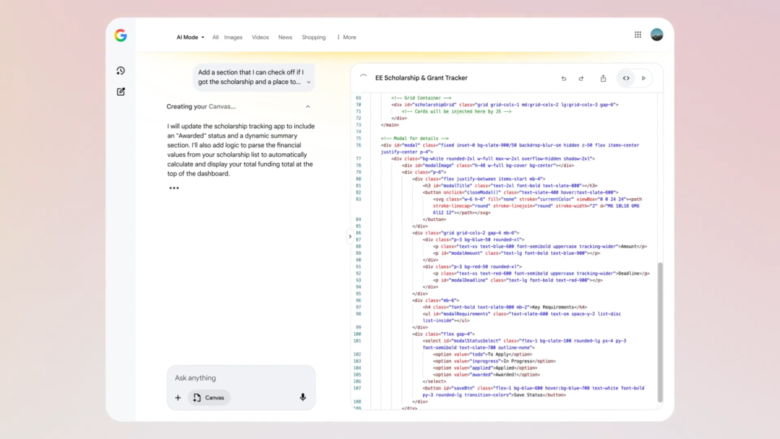

A OpenAI anunciou nesta quinta-feira (05/02) o modelo de inteligência artificial GPT-5.4. Pela primeira vez, um modelo da companhia vem com capacidade nativa de uso de computadores, o que significa que ele consegue executar tarefas em diferentes programas.

Para conseguir isso, o agente captura imagens da tela, entende as interfaces e envia comandos de mouse e teclado. Assim, ele pode resolver tarefas envolvendo, por exemplo, planilhas, documentos e apresentações.

Outra solução é escrever códigos para lidar com as tarefas — o GPT-5.4 também faz isso. A IA conta ainda com a capacidade de escolher a ferramenta certa para cada ocasião e, se for necessário, fazer a conexão com APIs.

Segundo a empresa, o GPT-5.4 é um modelo de raciocínio, o que significa que ele leva um tempo extra até chegar a uma resposta. Isso pode ser útil para agentes de IA, que receberiam um passo a passo com instruções mais precisas.

Como usar o GPT-5.4?

O GPT-5.4 já está disponível no ChatGPT para assinantes dos planos Plus, Team e Pro — usuários que não pagam vão ter que esperar, por enquanto. Ele aparece com a denominação GPT-5.4 Thinking. Ele também será oferecido na ferramenta de programação Codex e via API.

No chatbot, a interação é um pouco mais detalhada do que o habitual. O GPT-5.4 oferece primeiro um plano de raciocínio, descrevendo o que pretende fazer para chegar à resposta desejada. O usuário, então, pode fazer alterações no raciocínio, evitando ter que esperar uma resposta e não receber o resultado desejado.

O modelo também recebeu melhorias nos recursos para buscar e reunir informações de diversas fontes e, como em toda atualização, a promessa é que as respostas sejam mais factuais e haja menos alucinações.

OpenAI está em disputa com a Anthropic

Em dezembro de 2025, a OpenAI lançou o GPT-5.2 em tempo recorde. Na ocasião, rumores indicavam que a companhia estava trabalhando em “código vermelho” para barrar o crescimento do Gemini 3, que despontava como um competidor relevante para o ChatGPT.

Existem alguns paralelos possíveis entre aquele episódio e o lançamento desta quinta. O contexto, porém, é bem diferente.

Desta vez, a OpenAI está em uma briga com a Anthropic, e os motivos são diversos. As primeiras semanas tiveram provocações, como o comercial que satirizava as propagandas no ChatGPT. Depois, em um evento na Índia, Sam Altman, da OpenAI, e Dario Amodei, da Anthropic, se recusaram a dar as mãos durante uma foto com líderes do setor e o primeiro-ministro do país, Narendra Modi.

Os capítulos mais recentes, porém, são de outra ordem de importância. A OpenAI anunciou uma parceria com o Departamento de Defesa dos Estados Unidos, enquanto a Anthropic se recusou a fornecer ferramentas de IA para vigilância doméstica ou armas autônomas.

A discordância pública entre as companhias fez alguns usuários deixarem o ChatGPT como forma de protesto — não deve ser um movimento relevante em termos de quantidade, mas faz barulho nas redes sociais. O Claude, da Anthropic, recebeu de braços abertos os insatisfeitos.

Com informações da OpenAI e CNET

GPT-5.4 chega com capacidade nativa de usar computadores

GPT-5.4 chega com capacidade nativa de usar computadores

Fonte: Tecnoblog