CEO da Foxconn prevê que IAs acabarão com a mão de obra barata

CEO da Foxconn prevê que IAs acabarão com a mão de obra barata

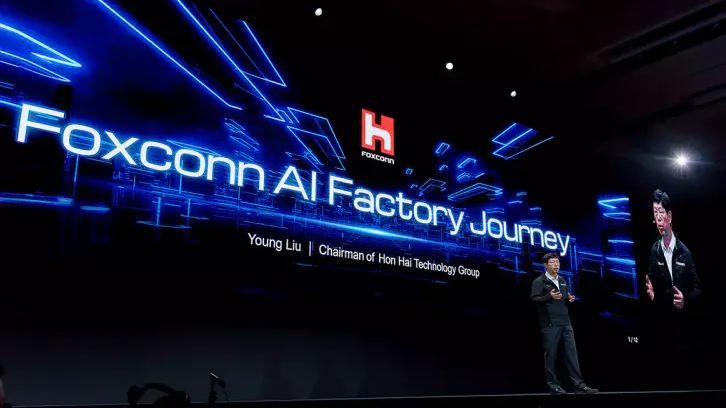

Inteligência artificial já está presente em algumas fábricas da Foxconn, mas combinada com trabalho humano (imagem: reprodução/Computex Daily)

Resumo

O CEO da Foxconn, Young Liu, afirmou que a IA substituirá a mão de obra barata e poderá reduzir pressões migratórias em países subdesenvolvidos.

A Foxconn já automatiza 80% da instalação de maquinário com IA generativa e desenvolve a FoxBrain, baseada no Llama 3 e 4.

Contudo, essa tendência pode reconfigurar cadeias produtivas, incentivando a produção nacional sem aumento proporcional de empregos.

O uso de mão de obra barata em países subdesenvolvidos pode acabar no futuro, disse Young Liu, CEO da Foxconn, durante uma palestra na Computex 2025. Na visão de Liu, as IAs serão utilizadas nas fábricas para acelerar a produção, diminuindo a dependência de humanos. A Foxconn já utiliza essa tecnologia em algumas de suas unidades ao redor do mundo — e as IAs estão indo bem.

Segundo Liu, o uso de inteligência artificial generativa também impacta questões migratórias e provoca mudanças nas políticas trabalhistas e econômicas dos países subdesenvolvidos. Em relação a esse último, Liu demonstra bastante otimismo, afirmando que, eventualmente, a exploração dos países pobres e, consequentemente, da mão de obra barata, tende a se esgotar.

Para resolver o esgotamento desses trabalhos, entram as IAs nas fábricas. Por outro lado, essa previsão de Liu pode beneficiar e também prejudicar nações ricas. O uso das IAs pode levar empresas a retomar a fabricação nacional, mas sem trazer milhares de empregos para nativos. Afinal, fábricas com IA necessitarão de mão de obra especializada nessa tecnologia — e provavelmente apenas um punhado de profissionais será capaz de lidar com essa tecnologia.

A Foxconn já usa IA generativa em suas fábricas?

Sim, a empresa passou a adotar uma IA para a instalação de maquinário nas fábricas. Cerca de 80% desse processo é feito pela inteligência artificial, mas ainda é necessário o uso de um humano para finalizar a instalação. Essa combinação acelera a montagem das linhas de produção das fábricas.

Foxconn testa uso de IA generativa para acelerar montagem (foto: Nadkachna/Wikimedia)

Na palestra, Liu também explicou que a IA auxilia na resolução de problemas na linha de montagem. Segundo o CEO, a Foxconn pensou que poderia trocar todos os humanos por IA, mas percebeu que isso não seria possível — talvez não por enquanto?

A empresa está desenvolvendo uma IA generativa, batizada de FoxBrain, com os LLMs Llama 3 e Llama 4 da Meta. O FoxBrain será uma inteligência artificial especializada nas tarefas de montagem e produção.

Outro uso de IA nas fábricas da Foxconn está no metaverso — no uso mais útil dessa tecnologia. A empresa utiliza a ferramenta Omniverse da Nvidia para criar um gêmeo digital das fábricas. Com isso, ela pode simular mudanças de layout e testar novas fábricas antes de iniciar a construção.

Por que o CEO da Foxconn vê a IA ligada ao movimento imigratório?

Hoje, parte da motivação da imigração está ligada a estrangeiros dispostos a trabalhar por salários baixíssimos — geralmente, nos empregos rejeitados por nativos. Um exemplo são os nipo-brasileiros que imigram para o Japão e vão trabalhar em fábricas, seja de forma temporária ou em imigração de longa duração. Com essa tecnologia presente nas fábricas, menos estrangeiros estariam dispostos a imigrar.

Com informações do The Register

CEO da Foxconn prevê que IAs acabarão com a mão de obra barata

CEO da Foxconn prevê que IAs acabarão com a mão de obra barata

Fonte: Tecnoblog