Google não tem planos para anúncios no Gemini, diz executivo

Google não tem planos para anúncios no Gemini, diz executivo

Demis Hassabis, CEO do Google DeepMind (foto: John Sears/Wikimedia)

Resumo

O Google não planeja inserir anúncios no Gemini, focando no aprimoramento do assistente.

OpenAI testa anúncios no ChatGPT para gerar receita, enquanto o Google prioriza a experiência do usuário.

Demis Hassabis afirma que empresas chinesas de IA estão seis meses atrás dos laboratórios ocidentais.

O Google não tem pretensão de inserir anúncios no Gemini tão cedo, ao contrário do que foi anunciado pelo ChatGPT nos últimos dias. A confirmação veio de Demis Hassabis, CEO da Google DeepMind, durante o Fórum Econômico Mundial em Davos, na Suíça.

Em entrevista ao portal Sources, o executivo afirmou que a empresa “não tem planos” de monetizar o chatbot via publicidade no momento, priorizando o desenvolvimento da tecnologia.

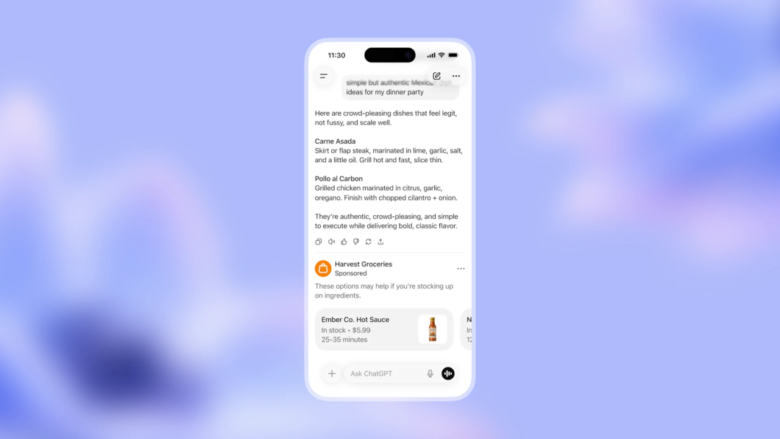

Como noticiamos aqui no Tecnoblog dias atrás, a OpenAI anunciou que começará a testar anúncios nas versões gratuita e Go do ChatGPT nos Estados Unidos. Para o chefe da DeepMind, “é interessante que eles tenham ido por esse caminho tão cedo. Talvez eles sintam que precisam gerar mais receita”.

Antes do anúncio da nova fonte de receita, um colunista do New York Times analisou a situação da companhia de Sam Altman e sugeriu que, em 18 meses, a empresa poderia enfrentar dificuldades. Ainda que não seja uma previsão oficial, tudo indica que o mercado está receoso com as finanças da OpenAI neste prazo.

Publicidade pode “contaminar” IA

Para o Google, a estratégia atual é transformar o Gemini num assistente melhor e onipresente. Hassabis demonstrou ceticismo sobre como a publicidade pode conviver com a proposta de uma inteligência artificial pessoal.

Durante a entrevista, o executivo explicou que o usuário espera que um assistente universal confiável tenha recomendações “genuinamente boas para você, imparciais e não contaminadas”. Segundo ele, misturar essa dinâmica com publicidade exige um cuidado extremo, pois “há muitas maneiras de fazer isso de forma errada”.

ChatGPT, rival do Gemini, começou a incluir anúncios na conversa com o chatbot (imagem: divulgação/OpenAI)

China: “seis meses atrás do Ocidente”

Além da alfinetada na rival, Hassabis também avaliou que as empresas de IA da China, como a startup DeepSeek, estão cerca de seis meses atrás dos principais laboratórios ocidentais em termos de tecnologia de ponta.

Segundo a Bloomberg, Hassabis classificou a reação do mercado ao modelo R1 da DeepSeek, lançado há um ano, como uma “reação exagerada e massiva”, mas reconheceu a qualidade dos avanços, em especial considerando as restrições de hardware impostas pelos Estados Unidos.

Para ele, embora as empresas chinesas sejam extremamente competentes em “alcançar a fronteira” tecnológica, elas “ainda precisam mostrar que conseguem inovar além dessa fronteira”.

Google não tem planos para anúncios no Gemini, diz executivo

Google não tem planos para anúncios no Gemini, diz executivo

Fonte: Tecnoblog